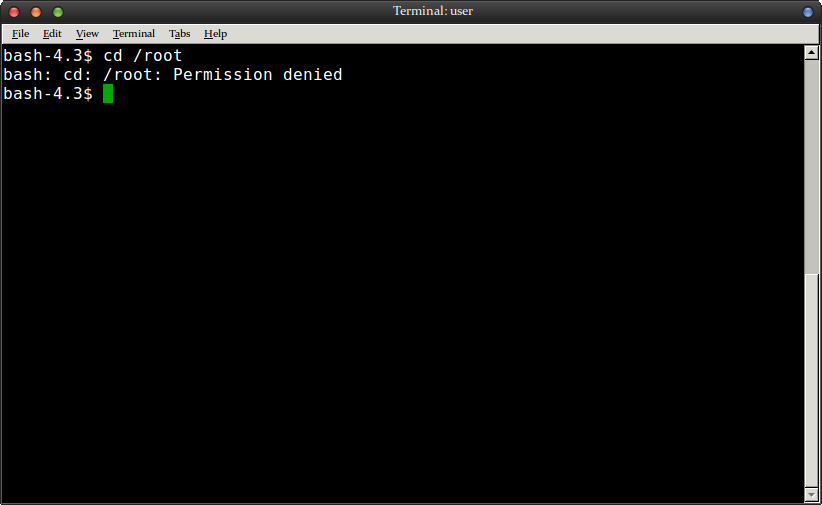

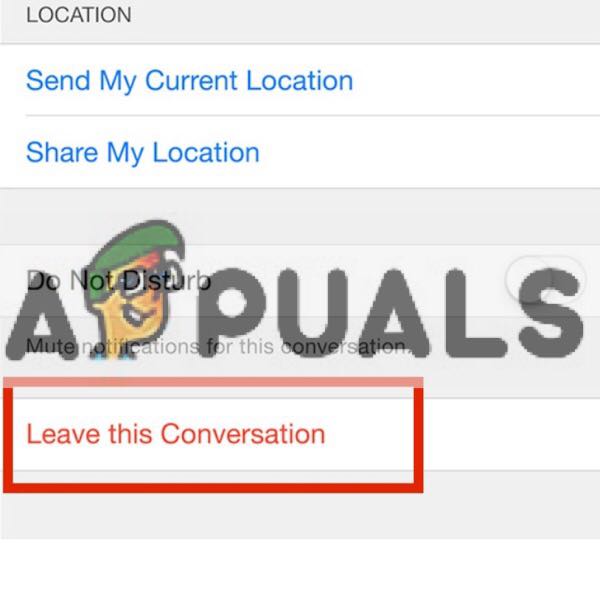

Reimatge de la fotografia espacial de la NASA per obtenir un resultat més clar. Vol espacial ara

NVIDIA és coneguda des de fa molt de temps per les seves immaculades unitats de processament de gràfics (GPU), el seu producte principal és la targeta NVIDIA GeForce. Amb això, la companyia sempre ha estat capdavantera en la investigació i el desenvolupament d’experiències que milloren la intel·ligència artificial en videojocs, disseny gràfic, processament de dades i vehicles d’automoció.

Darrerament, NVIDIA ha començat a centrar-se en la intel·ligència artificial de manera aïllada, amb el seu projecte més recent dedicant-se a la reimatge intel·ligent de fotografies preexistents mitjançant algoritmes gaussians per avaluar les diferències mínimes entre centenars d’imatges clares i borroses classificades en funció de la temperatura i la tonalitat. i després introduir aquests valors en les expressions de regressió de les fotografies borroses individuals per retrocedir al que podrien haver estat les seves imatges clares originals. Aquest procés es realitza individualment per a cada punt de la fotografia i s’utilitza una suma per generar un valor genèric de mínima diferència.

Oficina NVIDIA. Nasdaq a Twitter

L'algoritme funciona per aprendre dels intents anteriors del que indiquen certs colors i patrons a la pantalla. Quan es va desenvolupar el sistema, es tractava de milers d’imatges borroses i originals perquè la màquina pogués identificar quins patrons i colors de la pantalla corresponen a quins solcs i vores de la imatge original. Després d’haver estat provat moltes vegades, NVIDIA ha aconseguit ensenyar al seu xip AI a aprendre d’assajos anteriors i emmagatzemar una base de dades de codis gràfics coincidents que es converteixen en codi matemàtic en funció de la ubicació, el tint i la temperatura. Utilitzant l’experiència passada i les relacions establertes entre les imatges borroses i clares d’un mateix locus i tint, la màquina s’aconsegueix amb noves imatges, aplicant les fórmules que millor s’adapten al tint i a la temperatura de la nova foto. NVIDIA ha posat el seu algoritme en proves suficients per tenir una base de dades de retenció prou sòlida que la IA pot aprofitar quan treballa en imatges més noves i el mecanisme es manté tot sol, capaç de descobrir pràcticament qualsevol imatge gràcies a la seva formació en aprenentatge de reforç (RL) . Després de descobrir prou cares, per exemple, la màquina pot distingir cares borroses quan es posa a prova ja que entén quins solcs borrosos corresponen a quins trets facials en realitat. L'exposició a diferents tipus de soroll, com ara imatges estirades, emblanquinades, filtrades i amb textura, també s'ha afegit a la base de dades d'algoritmes.

A l’algoritme matemàtica en el llenguatge, el programa llegeix els llocs corresponents danyats i nets de les imatges corresponents, registrant x, y, x ’i y’ a la seva base de dades. A continuació, crea una corba de regressió gaussiana per fer coincidir les diferències entre les dues que permeten la conversió basada en el soroll fotogràfic general. En l'expressió de regressió de mínims quadrats generada, es pren el valor més baix que satisfà la condició i es representa una nova corba del valor gaussià. En convertir la imatge de nou a la seva qualitat clara original, la temperatura de cada punt es canvia en funció de la diferència del patró de regressió a la base de dades de la màquina d’IA que correspon a aquell color i patró en particular i cada punt es gira per produir una imatge clara. El mecanisme de corba gaussiana té en compte les formes més genèriques de soroll, però si el dispositiu és capaç d’identificar altres formes de soroll que sovint s’atribueixen a velocitats d’obturació no temporitzades o a ombres genèriques de la imatge, es fa una mitjana del valor gaussià de la diferència mínima Poisson del conjunt de dades (per al primer) i Bernoulli (per al segon) també valors de diferència mínima.

Reimatge de fotografies assistides per intel·ligència artificial. BT

En termes laics, el paper que juga la intel·ligència artificial en això és la detecció i conversió intel·ligents de fotos úniques basades en un conjunt de pràctiques que ja ha intentat el dispositiu. Quan es tracta del nivell d’intel·ligència artificial aconseguit avui, que encara es troba en una etapa en què no és particularment independent i els seus esforços es limiten a la gamma d’escenaris ja practicats, NVIDIA ha aconseguit molt en crear una màquina que pugui intentar i recrear fotos invisibles amb el màxim nivell de precisió adaptant i ampliant la seva base de dades de manera constant per millorar el percentatge d’èxit de les vendes de fotografies posteriors.